In questi anni di accelerazione tecnologica, un’ambigua utopia sta tornando a farsi strada nella cultura contemporanea: l’idea che le nuove conquiste dell’intelligenza artificiale, della big data analytics e dell’informatica quantistica ci permetteranno a breve di migliorare significativamente la nostra capacità di previsione, fino al punto da realizzare il sogno di Laplace di una macchina in grado di conoscere tutti gli istanti futuri a partire dall’analisi dei dati del presente. L’immaginario fantascientifico alimenta questa speranza: si pensi ai supercomputer quantistici nelle serie televisive Devs e Westworld, che sono in grado di predire il futuro a un grado di dettaglio che giunge al comportamento del singolo individuo, ben al di là di quanto sognava di fare la psicostoria di Isaac Asimov, che si accontentava di predire il comportamento collettivo di miliardi di esseri umani. Troviamo tracce di questa convinzione nel profluvio di nuove startup che promettono di utilizzare l’intelligenza artificiale per operazioni di forecast in una molteplicità di ambiti diversi, dai prezzi delle materie prime alla domanda di energia, dal costo del carburante ai mercati azionari, fino alle crisi internazionali. Una vera e propria bolla che sfrutta la crescente domanda delle aziende di strumenti che minimizzino i rischi in un’epoca di incertezza sistemica, riportando in auge l’antico sogno positivista di una “scienza del futuro” che emerse agli inizi del Novecento e trovò la sua massima espressione nei primi sviluppi dell’informatica del dopoguerra (Andersson, 2018). Sebbene a partire dagli anni Sessanta iniziasse a essere chiaro che la difficoltà di conoscere il futuro non è questione epistemica, ma ontologica, vale a dire che non è un problema di raffinamento degli strumenti, ma della differenza strutturale del futuro rispetto al passato, oggi sembra tornare di moda l’idea che sia solo questione di tempo prima che lo sviluppo tecnologico ci metta a disposizione uno strumento in grado di conoscere davvero il futuro (cfr. Nowotny, 2022; Lepore, 2023). A guardar bene le tendenze culturali della nostra contemporaneità, non c’è da meravigliarsi di questo revival positivista. Mai come oggi l’uso strumentale della tecnica ha assunto un ruolo dominante nella società, come mostra il cosiddetto “soluzionismo tecnologico” (Morozov, 2014), che vede nella tecnologia la soluzione a ogni problema, compreso quello dell’inconoscibilità del futuro. Mai come oggi il riduzionismo è così in voga, con la sua fede nella possibilità di ridurre la complessità umana a meri dati, a pura “informazione”, come tale calcolabile e quantificabile – dunque, prevedibile (cfr. Gambetta, 2016). Per questo, al fine di evidenziare le fallacie di questo ritornante discorso positivista sul futuro, occorre utilizzare gli stessi strumenti su cui esso ritiene di fondarsi, vale a dare sull’assunto della misurabilità, della certezza, del determinismo.

Logica del futuro

Iniziamo chiedendoci in cosa consista la previsione del futuro. Essa si basa su due presupposti:

- Che sia possibile inferire logicamente, a partire da certe premesse poste nel presente, una conseguenza posta nel futuro.

- Che sia possibile conoscere nel presente la possibilità che un dato evento si verifichi nel futuro.

Il primo presupposto può essere ricondotto alla regola del modus ponens, la più fondamentale delle regole d’inferenae della logica proposizionale: A→B, ossia se A allora B. Se manca la maggioranza sul voto di fiducia (A), il governo cade (B); è mancata la maggioranza, allora il governo cadrà. Le tabelle di verità introdotte da Frege e sviluppate a cavallo tra fine dell’Ottocento e i primi del Novecento permettono di dedurre se l’inferenza è vera a partire dai valori di verità delle premesse. In questo modo possiamo effettivamente giungere a delle deduzioni secondo quello che viene chiamato “calcolo della deduzione naturale”, basandoci su alcune semplici regole di inferenza. Nell’esempio (che traggo da Palladino, 2002) abbiamo cinque proposizioni: “La siccità persiste” (A); “L’agricoltura andrà in crisi” (B); “Aumenterà l’inflazione” (C); “Il governo aumenterà gli stipendi degli statali” (D)”; “I meteorologi hanno sbagliato le previsioni del tempo” (E). Abbiamo che A→B ossia che, se la siccità persiste, allora l’agricoltura andrà in crisi; introducendo la congiunzione “e” (^) otteniamo A^B→C vale a dire che se la siccità persiste e l’agricoltura va in crisi, allora aumenterà l’inflazione, che è una prima deduzione che possiamo ricavare dalle premesse e che risulta vera secondo le tavole di verità, da cui desumiamo anche A→C. Inoltre, applicando la regola del modus ponens possiamo ottenere che (A→C)→¬D ossia che se la siccità persiste e aumenta l’inflazione, allora il governo non aumenterà gli stipendi degli statali (introducendo il connettivo ¬ per “non”), e si può anche ricavare attraverso la regola del sillogismo disgiuntivo (o è vera un’affermazione o un’altra) D∨E ossia che, dal momento che il governo non ha aumentato gli stipendi degli statali (quindi D è falsa), allora i meteorologi hanno sbagliato le previsioni.

| A | B | A^B | A∨B | A → B |

| F | F | F | F | V |

| F | V | F | V | V |

| V | F | F | V | F |

| V | V | V | V | V |

Tuttavia, quello che la logica non fa né intende fare è affermare che la conclusione sia vera: tutto ciò che può fare è verificare se la conclusione segue logicamente dalle premesse. Da questo punto di vista è corretta anche la seguente inferenza: “Se esce un nuovo film di Nicholas Cage, allora aumentano le morti in piscina”; “esce un nuovo film di Nicholas Cage”, “le morti in piscina aumentano”. La premessa è vera fintanto che abbiamo dati che sostengono la correlazione, per cui ne deduciamo che la conclusione dev’essere corretta; e questo è il ben noto problema della differenza tra correlazione e causazione, che la logica proposizionale non affronta, perché tutto ciò che sa dirci è se una proposizione sia vera o falsa a partire dalle tabelle di verità. Peraltro, queste ultime ci pongono anche il caso di una conclusione vera a partire da una premessa falsa. Ciò appare più evidente quando si passa dalla logica proposizionale alla logica dei predicati, dove l’inferenza si basa su costanti predicative. Per esempio: “Tutti gli esseri umani sono mortali, tutti gli italiani sono essere umani, quindi tutti gli italiani sono mortali”, che possiamo esprimere esplicitando le proprietà della frase ossia P (essere umano), Q (essere mortale) e R (essere italiano) o secondo il formalismo logico:

∀x(Px→Qx)

∀x(Rx→Px)

∀x(Rx→Qx)

L’inferenza in questo caso viene dalla concatenazione tra premesse e conclusione, vale a dire che le premesse contengono al loro interno una stessa proprietà (P) attraverso cui colleghiamo nella conclusione le altre due proprietà, approdando così a una nuova verità. In questo modo possiamo correttamente inferire che, se Roberto (x) è un essere umano ed è italiano, allora prima o poi morirà. Se però affermiamo: “Tutti gli esseri umani sono immortali, chi è immortale è un dio, quindi tutti esseri umani sono dèi”, l’inferenza che ne traiamo è corretta ma la conclusione è falsa, poiché una delle due premesse è falsa. Può sembrare scontato accorgersi dell’esistenza di una premessa falsa, ma non sempre ciò accade così facilmente. Se sono convinto che la proposizione “tutti i cigni sono bianchi” sia vera, ossia ∀x(Cx→Bx), posso dedurre che qualsiasi animale non bianco non sia un cigno, ossia (introducendo il connettivo per “non”) ∀x(¬Bx→¬C) che però viene facilmente smentito una volta che mi imbatto in un cigno nero in Australia.

Questi limiti della logica sono ben noti, ma ciò non ci impedisce di strutturare il linguaggio informatico sulla logica, anche perché nel dominio dell’informatica le proposizioni sono di tipo binario, sono cioè sempre o vere o false, cosa che nella realtà non sempre accade. Il problema si verifica quando cerchiamo di applicare il formalismo logico a fenomeni più complessi, per i quali non solo è difficile attribuire la proprietà “vero” o “falso”, ma anche stabilire un corretto modus ponens. Wittgenstein, nel suo Tractatus logico-philosophicus, ci ha messo in guardia da tutto questo:

5.132 (…) Il modo della conclusione è da ricavarsi solo dalle due proposizioni. Esse ed esse soltanto possono giustificare la conclusione. «Leggi d’inferenza» che – come in Frege e Russell – giustifichino le conclusioni, sono prive di senso, e sarebbero superflue.

5.133 Ogni inferenza avviene a priori.

5.134 Da una proposizione elementare non può inferirsene un’altra.

(…)

5.136 Un nesso causale, che giustifichi una tale conclusione, non v’è.

5.1361 Gli eventi del futuro non possiamo arguirli dagli eventi presenti. La credenza nel nesso causale è la superstizione.

5.1362 Il libero arbitrio consiste nell’impossibilità di conoscere ora azioni future. Noi le potremmo conoscere solo la causalità fosse una necessità interiore, come quella della conclusione logica. (…)

(Wittgenstein, 1964)

Necessità e possibilità

Se oggi continuiamo a credere nel nesso causale in logica è perché crediamo nell’esistenza di necessità interiori dei fenomeni, per usare il linguaggio di Wittgenstein. Certamente esistono fenomeni che possiedono una necessità interiore, ossia che sono spinti da leggi deterministiche. “Se lancio una palla in aria, essa cadrà” si basa sulla legge di gravitazione universale, valida anche al di fuori della Terra (cadrà in ogni caso verso il centro di massa maggiore). L’illusione positivistica si fonda proprio sulla convinzione che sia possibile individuare queste leggi deterministiche anche in fenomeni sociali complessi. Non sarebbe dunque vero che un fenomeno sociale è ontologicamente diverso da un fenomeno naturale. August Comte nell’Ottocento la pensava così quando pose le basi della fisica sociale: «La fisica sociale è quella scienza che si occupa di fenomeni sociali, considerati allo stesso modo dei fenomeni astronomici, fisici, chimici e fisiologici, vale a dire come soggetti a leggi naturali e invariabili, la cui scoperta è l’oggetto speciale delle sue ricerche» (Comte, 1969). Se all’epoca questo sforzo non è approdato a risultati empirici, facendo naufragare anche la futurologia empirico-positivista della prima metà del Novecento, la speranza che oggi vediamo tornare in auge è di poter utilizzare i più potenti mezzi del machine learning per inferire leggi deterministiche nei fenomeni complessi che finora ci sono sfuggite: basterà dare in pasto agli algoritmi un’enorme mole di dati per vedere se è possibile ottenere dei nessi causali che non abbiamo ancora visto. L’assunto è quindi che esista solo una differenza di ordine epistemico tra fenomeni naturali e sociali, e che migliorando la nostra capacità di analisi questa differenza venga meno.

Qui ci viene in aiuto Max Weber, che della questione aveva ampiamente trattato nel suo saggio del 1906 su Possibilità oggettiva e causazione adeguata nella considerazione causale della storia. Weber si poneva il problema «di stabilire mediante quali operazioni logiche cogliamo, e possiamo giustificare dimostrativamente, il fatto che esiste una siffatta relazione causale tra quegli elementi “essenziali” dell’effetto e determinati elementi entro l’infinità dei momenti determinanti» (Weber, 1997), ossia detta in altri termini come possiamo individuare attraverso procedimento logico un nesso causale tra causa ed effetto nelle scienze storico-sociali. Nel provare a fornire una risposta, Weber entrava in polemica tanto con l’idea positivistica della storia come rigida concatenazione oggettiva di fatti, in cui gli eventi storici sono essenzialmente da leggi di natura e secondo cui, riprendendo la celebre ipotesi di Laplace, sarebbe possibile conoscere gli eventi futuri partendo da una perfetta conoscenza della configurazione di tutti gli elementi del presente (inclusi i singoli individui), quanto con la concezione storicistica fondata sulla necessità di un certo sviluppo storico, come per esempio nel marxismo che spiega tutti i fenomeni sociali in termini di rapporti economici. Egli individuava nella categoria della “possibilità” la sostanziale differenza con i fenomeni naturali, che si fondano sulla “necessità”. La possibilità non è una misura della nostra ignoranza, ma per Weber ha carattere nomologico, ossia è il frutto di specifiche leggi che regolano gli accadimenti: tali avvenimenti possono verificarsi in molti modi possibili e quindi generano diversi scenari, che Weber chiama “quadri fantastici”. Attraverso di essi possiamo riuscire a trovare le cause determinanti di un fenomeno, costruendo degli scenari controfattuali in cui un determinato evento non si è verificato: se non avesse piovuto il giorno prima di Waterloo, Napoleone non avrebbe aspettato la tarda mattinata per lanciare l’attacco, dovendo attendere che il fango si asciugasse per rendere efficace il tiro di artiglieria; ma d’altro canto, anche senza pioggia, l’incapacità di Grouchy di impedire al corpo prussiano di von Bulow di giungere nel pomeriggio sul pianoro di Waterloo avrebbe comunque determinato lo stesso esito per Napoleone, dal che desumiamo che non è stata la pioggia la causa della sconfitta ma un grave errore tattico.

I concetti di “necessità” e “possibilità” discussi da Weber sono stati introdotti in logica attraverso la branca della logica modale, che si occupa del “modo” in cui una proposizione è vera o falsa. L’introduzione della logica modale è stata una delle soluzioni al problema posto già da Aristotele sulla impossibilità di conoscere nel presente se un asserto relativo al futuro sia vero o falso, che è il secondo dei temi che avevamo posto in apertura, ossia il problema dei futuri contingenti (cfr. Iaquinto e Torrengo, 2018). Nel celebre esempio aristotelico, “Domani ci sarà una battaglia navale” non può essere dichiarato oggi vero o falso. Se accogliessimo la concezione fatalista di Aristotele, per cui il futuro è ontologicamente identico al passato e quindi predeterminato, affermare che la proposizione è vera implicherebbe la necessità della sua verità, ossia che una battaglia navale è un evento che non può non accedere. Analogamente, affermare che è falsa significherebbe che necessariamente la battaglia non si verificherà, in virtù di leggi deterministiche. Al concetto di necessità, il cui operatore modale è □, il non fatalista contrappone il concetto di possibilità, il cui operatore modale è ◊. Diciamo dunque che ◊A↔¬□A ossia che è possibile che una battaglia navale ci sarà domani se e solo se non è necessario che una battaglia navale non ci sia, e che □A ↔¬◊A ossia che è necessario che una battaglia navale domani ci sarà domani se e solo se non è possibile che una battaglia navale non ci sia. Abbiamo tuttavia stabilito che la necessità è propria dei fenomeni naturali per i quali vige un nesso causale di tipo deterministico. “Tra 365 giorni la Terra si troverà di nuovo in questo punto della sua orbita intorno al Sole” è un’affermazione sul futuro che si determina necessaria in ragione, di nuovo, della legge di gravitazione universale. “Domani il governo cadrà perché non ha avuto la maggioranza al voto di fiducia” resta una possibilità, poiché sappiamo che esistono molti casi in cui un governo è rimasto in carica perdendo un voto di fiducia in Parlamento. In questo caso quello che abbiamo è un insieme di scenari futuri, che in logica sono detti anche “mondi possibili” (cfr. Frixione, Iaquinto e Vignolo, 2016). Un evento A è necessariamente vero (ossia □A→1 dove “1” è valore di verità, opposto al valore “0” per falso) se e solo se A→1 in tutti i mondi possibili, mentre diciamo che è possibile che sia vero (ossia ◊A→1) se e solo se A→1 in almeno un mondo possibile.

Superdeterminismo

Possiamo dibattere sullo statuto metafisico di questi mondi possibili – se cioè esistano davvero, come per esempio afferma l’ipotesi dei molti mondi nella meccanica quantistica, o esistano solo in potenza e solo uno di essi si attualizza nella realtà – ma la questione qui non ci interessa. Quel che ci interessa è che di un’ipotesi sul futuro relativa a fenomeni di tipo storico-sociale possiamo dire esclusivamente che è possibile, mai che è necessaria, a meno di non accogliere una concezione deterministica della storia. Possiamo escluderla del tutto? Nella serie Devs abbiamo a che fare con un universo superdeterministico, dove di fatto le condizioni iniziali determinano tutti gli eventi successivi, senza alcuno scampo. Si tratta di un’idea ritornata in auge in anni recenti nella filosofia della fisica per ovviare al problema della misurazione quantistica, che ci restituisce un mondo non deterministico ma pone un enorme serie di problemi e paradossi (tra cui quello del famoso gatto di Schrödinger) che sembrerebbero suggerire che la teoria sia incompleta. Laddove i fenomeni quantistici rispondono a un’evoluzione deterministica nella loro essenza, essendo descritti da un’equazione deterministica che è quella di Schrödinger, nel processo di misurazione passano a un livello probabilistico e quindi dalla necessità alla possibilità (di qui l’ipotesi dei molti mondi come possibile soluzione). Se tuttavia si ammette che tutti i risultati di tutte le misurazioni possibili nella storia dell’universo siano già determinati ab origine, allora l’indeterminismo è solo epistemico e non ontologico, vale a dire che l’esito dell’atto di misurazione è probabilistico solo a causa della nostra ignoranza sulle condizioni iniziali e non perché la struttura fisica della realtà a livello fondamentale sia indeterminata. L’esito della misurazione è necessario in tutti i mondi possibili, secondo l’interpretazione superdeterminista (cfr. Hossenfelder e Palmer, 2020).

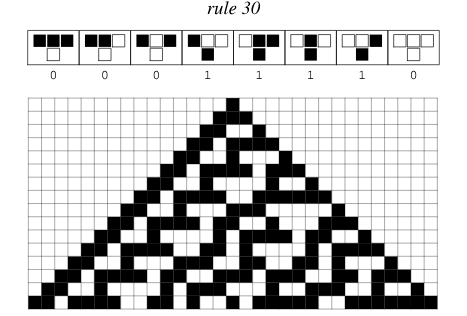

Tuttavia, torniamo di nuovo al problema di Weber: se anche il superdeterminismo fosse vero a livello fondamentale della realtà, ciò si applicherebbe anche ai fenomeni sociali? Perché ciò possa avvenire, dobbiamo postulare la riducibilità dei fenomeni sociali a conseguenze di leggi di natura. Questa era l’ambizione del positivismo quando cercava di ridurre l’essere umano a un atomo sociale: poiché abbiamo leggi che descrivono deterministicamente il comportamento degli atomi, possiamo avere leggi che descrivono deterministicamente il comportamento degli esseri umani. Possiamo cioè individuare quei nessi casuali che ci permettono di dire non solo che A→B, ma che dato A allora □B→1 anche nel caso dei fenomeni sociali. Il ruolo che nell’Ottocento aveva l’atomo come elemento fondamentale a cui ridurre l’essere umano oggi è assunto dal bit, l’atomo di informazione. Sempre più si diffonde nella fisica la convinzione che si possa ridurre l’intera complessità del reale a informazione, secondo la celebre sintesi di John Wheeler it from bit. Per esempio, la teoria degli automi cellulari proposta da John von Neumann e resa celebre dal Gioco della vita di John Conway presuppone che sia possibile, a partire da una configurazione di base elementare e da poche leggi fondamentali, ottenere un’evoluzione che origini forme complesse, compresa forse la vita cosciente. Di sicuro l’informatico Stephen Wolfram, nei suoi recenti sviluppi della teoria degli automi cellulari, ritiene possibile ottenere tanto la meccanica quantistica quanto la relatività generale (ossia le due teorie fondamentali della fisica) da una teoria computazionale, fondata sull’idea che l’universo sia “computazionalmente equivalente” a un automa cellulare, e poiché è possibile ottenere automi cellulari che sono Turing-completi, ossia in grado di svolgere qualsiasi calcolo, allora si può dire che l’universo è computazionalmente equivalente a un computer (cfr. Dyson, 2000; Wolfram, 2020).

Queste idee non possono non piacere a quanti ritengono che, una volta ridotta a fondamenti di base la complessità del reale, anche i comportamenti umani potranno essere ricondotti a leggi deterministiche formulabili in termini logici, e quindi calcolabili attraverso un computer, una volta in possesso di un computer sufficientemente avanzato da svolgere tutti i calcoli. Si tratta di un’idea molto diffusa negli ambienti del soluzionismo tecnologico, che già da tempo si baloccano con l’idea che, se tutto è informazione, allora è solo questione di tempo prima che sia possibile svincolare l’informazione di un essere umano dal suo hardware originario (il corpo biologico) e farlo girare su un cloud più performante. Il sogno dell’intelligenza artificiale, del resto, si basa essenzialmente su quest’assunto. Perché è importante sostenere, come fa Wolfram, che l’universo sia riducibile a una macchina di Turing? Perché secondo il teorema di Church-Turing possiamo definire calcolabile tutto (e solo) ciò che può essere calcolato da una macchina di Turing. Se ammettiamo che un computer è computazionalmente equivalente a una macchina di Turing universale, e accettiamo la dimostrazione di Wolfram secondo cui l’universo è computazionalmente equivalente a un computer, ciò implica che tutto quel che l’universo contiene è calcolabile. Questo significa che non esisterebbero proposizioni indecidibili, vale a dire per le quali non è possibile provare se siano vere o false senza svolgere l’intero calcolo logico, che in alcuni casi può andare avanti per un numero enorme di iterazioni e quindi essere sostanzialmente indecidibile (cfr. Davis, 2012). La logica proposizionale è decidibile, perché le tavole di verità sono sufficienti a dirci se una proposizione è vera o falsa. Secondo il teorema di Church, la logica dei predicati è invece indecidibile perché richiede la verifica di ogni singolo passaggio, e se per una proposizione vera i passaggi sono finiti, per una proposizione falsa ciò richiede un numero non finito di passaggi, il che non ci consente di dire che siamo di fronte a una proposizione falsa, dal momento che a un certo momento il calcolo potrebbe fermarsi e dimostrarsi vera: ma non lo sappiamo. È il cosiddetto “problema della fermata”, fondamentale per gli sviluppi del machine learning, perché in moltissimi calcoli a partire da determinati input gli algoritmi possono non essere in grado di fornire un output e vanno in loop. Il problema della fermata è indecidibile, ossia non siamo in grado di sapere, dato un determinato algoritmo (equivalente a una macchina di Turing) e un numero naturale come input, se l’algoritmo con quell’input terminerà il calcolo in un numero finito di passi o se il calcolo andrà avanti all’infinito (cfr. Palladino, 2004). L’esistenza di funzioni non computabili è un colpo durissimo a ogni tentativo di ridurre la realtà a informazione calcolabile. Nonostante la sua essenza risalga ai celebri teoremi di Gödel, oggi sembra che queste scoperte fondamentali della logica siano state dimenticate. Analogamente, sembra essere dimenticata una verità essenziale, vale a dire che, se anche tutta la realtà fosse informazione, la teoria dell’informazione è regolata dalla seconda legge della termodinamica, che è di tipo statistico e non deterministico. Che un cubetto di ghiaccio si sciolga in una tazza di tè caldo e non il contrario non è il frutto di leggi deterministiche, ma statistiche: è semplicemente estremamente più probabile che si osservi il primo fenomeno piuttosto che il secondo. Poiché Claude Shannon ha dimostrato già negli anni Quaranta che la teoria dell’informazione è descritta dalla seconda legge della termodinamica, se ne deduce che, se anche tutta la realtà fosse informazione, di essa possiamo ottenere solo verità parziali, non definitive (cfr. Glieck, 2015; Seife, 2023). E questo dovrebbe chiudere la porta a ogni superdeterminismo.

Probabilità

Una volta esclusa l’ipotesi della necessità dei fenomeni storico-sociali, restiamo solo con la possibilità. Dobbiamo dunque concludere che possiamo ottenere solo conoscenze parziali sul futuro, e questo è un fatto che la struttura stessa del mondo, espressa in termini logico-matematici, ci dimostra. Lo stesso Eugene Wigner, sostenitore della “irragionevole efficacia della matematica”, ci metteva in guardia dall’errore di credere possibile prevedere il futuro attraverso le leggi di natura, anche possedendo una piena e completa conoscenza dei dati del presente (Wigner, 2017). Che possiamo acquisire solo conoscenze parziali sul futuro non significa che dobbiamo fermarci qui. È chiaro che una volta di fronte a delle possibilità, ossia ai mondi possibili che la logica modale ci permette di esplorare, siamo portati ad assegnare a ciascuno di essi una misura di probabilità. Abbiamo visto che la stessa natura dei fenomeni complessi, descritti dalla termodinamica (ossia dalla meccanica statistica) ci spinge verso l’ambito della probabilità anziché delle certezze deterministiche. In fin dei conti, dire che è altamente probabile che il cubetto di ghiaccio si sciolga in una tazza di tè caldo al punto che affinché si possa osservare il fenomeno contrario occorrerebbe molto più dell’età dell’universo, è quasi come dire che è pressoché certo. La probabilità è una misura di incertezza e il nostro compito di fronte al problema di conoscere qualcosa del futuro consiste nel ridurre questa incertezza. È tuttavia forte la tentazione di fornire al calcolo della probabilità un’interpretazione deterministica, dimenticando o ignorando la fonte delle stime che attribuiamo a un evento (o a un mondo possibile, ossia a uno scenario).

Nell’approccio frequentista la probabilità è data dal numero di prove con esito favorevole diviso per il numero totale delle prove, il che implica che quanto maggiore è il numero totale delle prove, tanto più la stima è migliore. Se vogliamo stimare la probabilità che il governo cada dopo essere andato sotto nel voto di fiducia in Parlamento, possiamo raccogliere tutti i casi in cui un governo ha messo la fiducia su una legge senza avere la maggioranza dei voti e vedere in quanti casi ciò ha comportato la caduta del governo. Potremo così dire che c’è l’80% di probabilità che tale esito si verifichi. Così stiamo però ignorando tutta una serie di condizioni al contorno, poiché non è detto che le condizioni sociali, storiche, politiche, psicologiche, culturali che avevano determinato quell’esito, poniamo, dieci anni fa, siano ancora valide. In tal caso la stima di probabilità ci dice molto poco sull’esito che possiamo aspettarci. Ben più complesso è il caso in cui dobbiamo fare un’ipotesi sul futuro in assenza di esempi storici su cui basarci; possiamo provare a ragionare per analogia, ma quello dell’analogia è un terreno scivoloso. Il metodo Delphi, su cui si sono fondati anche rigorosi tentativi di misurare i possibili diversi esiti di una guerra nucleare, prevede di assegnare alle diverse ipotesi un grado di probabilità che deriva dalla propria esperienza soggettiva (cfr. Marbach, 1991). Ciò sembra essere l’unica soluzione possibile quando si tratta di assegnare misure di probabilità a eventi futuri che non si sono ancora verificati, come quello di uno scontro nucleare tra Stati Uniti e Russia (che si spera non si verifichi mai). Tuttavia, il concetto di probabilità soggettiva provoca fortissime resistenze nella nostra epoca contemporanea fondata sulla religione del dato e dell’oggettività e sembra sminuire i tentativi di ridurre la soggettività di una previsione per ottenere un’inferenza che sia solidamente fondata. Nessuno vorrebbe sentirsi dire che la possibilità che i Campi Flegrei eruttino entro i prossimi 12 mesi con un’eruzione di tipo pliniano sia del 70%, se tale stima è frutto dell’esperienza soggettiva di un singolo ricercatore. Se anche tale stima emergesse da un Delphi tra un gran numero di esperti, tenderemmo a considerarla poco convincente, perché resta comunque soggettiva.

Uno dei grandi pionieri italiani degli studi sul futuro, Bruno de Finetti, il cui contributo alla statistica e alla matematica continua a essere fonte di scoperte (sebbene la maggior parte delle sue opere oggi siano fuori commercio), sosteneva in modo solo apparentemente provocatorio che la probabilità è sempre soggettiva e che di fatto la probabilità oggettiva non esiste. Entrambe le stime possono essere trattate nello stesso modo, ossia operativizzate, vale a dire rese in una forma tale da permetterci di eseguire i calcoli previsti dalla teoria della probabilità. L’operativizzazione della probabilità soggettiva è uno degli obiettivi degli approcci quantitativi al Delphi che, pur basandosi su opinione, cerca di ottenere ipotesi su eventi futuri attraverso le quali ridurre l’incertezza e assumere decisioni. D’altro canto, in metodi come la matrice di impatto incrociato, che si basa su valori probabilistici di tipo soggettivo (spesso attraverso Delphi), si impiega un’altra tecnica del calcolo delle probabilità che è il metodo Monte Carlo, che consiste nel fornire numeri aleatori a ciascun possibile evento e iterare per un n numero di volte tale assegnazione casuale al fine di generare mondi possibili in cui si verificano certe combinazioni di eventi e altri in cui se ne verificano altre. Questo tipo di approccio basato sulla pura casualità può sembrare quanto di meno scientifico possa esserci, se per scientifico intendiamo “deterministico”; ma riproduce la casualità del reale e permette di inserirla negli scenari. Ciò ci consente comunque di effettuare analisi di mondi possibili e anche di assegnar loro delle probabilità. Ma torniamo a de Finetti: il suo teorema sostiene un fatto foriero di conseguenze, ossia che una probabilità soggettiva non può che essere coerente. «Un individuo che nel giudicare delle probabilità di certi eventi contraddice un teorema delle probabilità non è coerente» (de Finetti, 1931). Il teorema si fonda sul fatto che l’assegnazione da parte di un soggetto di un certo grado di probabilità che un dato evento si verifichi tende a massimizzare la possibilità di avere ragione. Se infatti io decidessi di scommettere su un determinato esito di un evento, per esempio di una partita di calcio, facendo delle stime di probabilità scorrette, alla fine perderei sempre; un agente razionale, secondo de Finetti, non può avere credenze che violano gli assiomi della probabilità.

Non a caso, “agente razionale” è un modo con cui definiamo tanto un essere umano dotato di raziocinio, quanto un algoritmo. Ma de Finetti avrebbe molto da ridire sulla nostra propensione a giudicare un algoritmo più efficace nel fornire una stima di probabilità a un dato scenario, poiché le sue stime non sono più oggettive dell’agente razionale umano. Sbaglierebbero gli esperti di machine learning a replicare – come certamente molti penserebbero di fare – che l’efficacia maggiore degli algoritmi dipende dalla loro capacità di elaborare previsioni sulla base del teorema di Bayes, che consente di adattare di volta in volta le credenze definite a priori con l’osservazione dei dati effettuata a posteriori: questa infatti è una cosa che ogni essere umano dotato di raziocinio può e deve fare ed è ampiamente prevista dai metodi come il Delphi, nel quale l’esperto cambia la sua stima nei round successivi se messo di fronte a nuovi dati che lo spingono a rivedere la propria opinione. Semplicemente, una macchina può effettuare questa correzione in modo decisamente più rapido. Quando un algoritmo LLM (large language models) produce un testo dotato di senso attribuendo stime di probabilità alle sequenze di parole, rivede e migliora tali stime man mano che aumenta il campione di testi a cui può attingere. Ma il teorema di Bayes non è niente di più che un approccio probabilistico soggettivista; chi pensa di potergli assegnare un grado di oggettività solo perché svolto da un algoritmo sta cadendo nella fallacia positivista (cfr. Russell e Norvig, 2021). Non solo: esso condivide anche tutti i limiti delle inferenze logiche che abbiamo ricordato sopra e finisce per generare output che sono il più probabilisticamente vicini ai suoi input. Di tutti i mondi possibili, sceglie sempre quelli più simili al presente. Ma questo non c’è di alcun aiuto nell’ambito della conoscenza del futuro, perché se c’è una cosa che abbiamo imparato del futuro è che esso non è mai come ce lo aspettiamo.

Ciò ci conduce alla conclusione di queste riflessioni. Certamente di un certo evento futuro possiamo ottenere solo una conoscenza di tipo probabilistico, ma non dovremmo limitarci a questo. Il peggio che potremmo fare sarebbe infatti quello di considerare come l’unico mondo possibile quello più probabile, che è il tipo di ragionamento a cui ci spinge l’approccio algoritmico al futuro. A fronte dei limiti della nostra capacità di inferire conoscenza sul futuro in modo logico, dovremmo impegnarci non a restringere, ma ad allargare il dominio dei mondi possibili. Tra di essi, infatti, possono non solo celarsi eventi a venire che nemmeno riusciamo a immaginare, ma anche idee, soluzioni, concezioni che ci rifiutiamo di vedere ma che potrebbero fungere da aiuto per il tempo presente. Tra di essi, inoltre, si nasconde quel “futuro desiderabile” che, per quanto poco probabile, rappresenta l’obiettivo a cui dovrebbe tendere la nostra tensione verso il domani. «Bisogna anzitutto allargare la capacità di pensare come possibili o ammissibili cose che ai più non sembrano ancora tali, per giudicare se sarebbero desiderabili», scriveva molti anni fa de Finetti. Egli riconosceva che il nostro vero limite non è nella previsione, ma nella capacità di immaginazione. Potremmo diventare sempre più logici e macchinici nei nostri tentativi di prevedere il futuro, ma di fronte alle incognite che si celano davanti a noi questo approccio sarebbe deleterio. Piuttosto, come ancora ci esortava de Finetti: «Occorre pensare in termini di utopia, perché ritenere di dover affrontare efficacemente i problemi in maniera diversa è ridicola utopia» (de Finetti, 1968).

Bibliografia

- Jenny Andersson, The Future of the World: Futurology, Futurists, and the Struggle for the Post Cold War Imagination, Oxford University Press, Londra-New York, 2018.

- August Comte, Opuscoli di filosofia sociale e discorsi sul positivismo, Sansoni, Firenze, 1969.

- Martin Davis, Il calcolatore universale. Da Leibniz a Turing, Adelphi, Milano, 2012.

- Bruno de Finetti, Sul significato soggettivo della probabilità, in “Fundamentae Mathematicae”, vol. 17, 1931.

- Bruno de Finetti, Riflessioni sul futuro, in “Civiltà delle Macchine”, n. 3, 1968.

- George B. Dyson, L’evoluzione delle macchine. Da Darwin all’intelligenza globale, Raffaello Cortina, Milano, 2000.

- Marcello Frixione, Samuele Iaquinto, Massimiliano Vignolo, Introduzione alle logiche modali, Laterza, Bari-Roma, 2016.

- Daniele Gambetta (a cura di), Datacrazia. Politica, cultura algoritmica e conflitti al tempo dei big data, D Editore, Ladispoli, 2016.

- James Glieck, L’informazione, Feltrinelli, Milano, 2015.

- Sabine Hossenfelder, Tim Palmer, Rethinking Superdeterminism, in “Frontiers in Physics”, vol. 8, 6 maggio 2020.

- Samuele Iaquinto, Giuliano Torrengo, Filosofia del futuro. Un’introduzione, Raffaello Cortina, Milano, 2018.

- Jill Lepore, Simulmatics. Ascesa e caduta dell’azienda che inventò il futuro, Rizzoli, Milano, 2023.

- Giorgio Marbach, Il punto sul metodo Delphi, in Giorgio Marbach, Claudio Mazziotta, Alfredo Rizzi, Le previsioni. Fondamenti logici e basi statistiche, Etas, Milano, 1991.

- Evegeny Morozov, Internet non salverà il mondo, Mondadori, Milano, 2014.

- Helga Nowotny, Le macchine di Dio. Gli algoritmi predittivi e l’illusione del controllo, Luiss University Press, Roma, 2022.

- Dario Palladino, Corso di logica. Introduzione elementare al calcolo dei predicati, Carocci, Roma, 2002.

- Dario Palladino, Logica e teorie formalizzate. Completezza, incompletezza, indecidibilità, Carocci, Roma, 2004.

- Stuart J. Russell, Peter Norvig, Intelligenza artificiale. Un approccio moderno, 4° edizione, 2 voll., Pearson, Torino, 2021.

- Charles Seife, La scoperta dell’universo. I misteri del cosmo alla luce della teoria dell’informazione, Bollati Boringhieri, Torino, 2013.

- Max Weber, Il metodo delle scienze storico-sociali, Einaudi, Torino, 1997.

- Ludwig Wittgenstein, Tractatus Logico-Philosophicus e Quaderni 1914-1916, Einaudi, Torino, 1964.

- Stephen Wolfram, Finally We May Have a Path to the Fundamental Theory of Physics… and It’s Beautiful, StephenWolfram.com, 14 aprile 2020.