In due precedenti contributi su Futuri, mi sono occupato della genealogia del concetto di rischio esistenziale e delle diverse classificazioni di questo tipo di rischi. Questo terzo e ultimo contributo sull’argomento completa la trattazione, riprendendo un intervento che ho tenuto al convegno “Anticipation, Agency and Complexity” tenutosi all’Università di Trento lo scorso aprile, nel quale ho proposto l’impiego della nozione di rischio esistenziale al posto del tradizionale principio di precauzione nella governance del progresso tecnoscientifico, per una serie di motivazioni che delineo nella parte finale di questo articolo. Dopo aver discusso delle radici storiche di questa nozione e di quali possono essere oggi i rischi esistenziali per la civiltà umana, analizzo qui le attività di ricerca portate avanti in questo ambito negli ultimi anni attraverso tre centri di ricerca: il Future of Humanity Institute di Oxford, il Center for the Study of Existential Risk di Cambridge, e il Future of Life Institute di Cambridge, Massachusetts.

Il Future of Humanity Institute

Da quando ha ricevuto una sua definizione formale, il concetto di rischio esistenziale ha iniziato ad assumere una crescente rilevanza nella ricerca accademica. La fondazione, nel 2005, del Future of Humanity Institute (FHI) all’Università di Oxford, ha senza dubbio fornito un importante stimolo in tal senso. A fondarlo è Nick Bostrom, docente a Oxford e primo teorico della nozione di “rischio esistenziale”. all’interno della Oxford Martin School, all’epoca James Martin 21st Century School. Nata grazie a una generosa donazione di James Martin, autore di influenti testi sulla società dell’informazione e le sfide del nuovo secolo, la Oxford Martin School si occupa di ricerche sulle “più pressanti sfide e opportunità globali del XXI secolo”. Negli anni, il FHI ha portato avanti un’azione incisiva sulla società civile per aumentare la consapevolezza dei rischi esistenziali legati alle nuove tecnologie. Tra il 2008 e il 2010, il FHI pubblica 22 paper su riviste scientifiche, 34 capitoli in volumi collettanei, svolge 95 conferenze come invited lecturers, oltre cento apparizioni sui media, e consulenze per enti influenti come il World Economic Forum, il Cabinet Office britannico, il Parlamento europeo. Nel 2011 Bostrom e Milan M. Ćirković curano il volume Global Catastrophic Risks, edito dalla Oxford University Press, che sintetizza le ricerche svolte dal FHI e fornisce una nuova definizione di rischio esistenziale, non a caso definito non più “esistenziale” ma “globale”: i Global Catastrophic Risks (CGRs) sono eventi catastrofici che causano almeno 10 milioni di morti o 10 trilioni di dollari di danni. Nel volume sono elencati e trattati in capitoli separati 13 GCR divisi in tre categorie: “rischi naturali”, “rischi da conseguenze indesiderate”, “rischi da atti ostili”.

Oltre all’individuazione dei GCR, il FHI nella prima fase della sua attività di ricerca si concentra sullo sviluppo di una macrostrategia per affrontarli. Lo sviluppo di questa macrostrategia comprendere l’analisi dettagliata delle capacità e dei potenziali impatti delle tecnologie future, valutazione del rischio esistenziale, questioni etiche (legate per esempio ai temi del potenziamento umano, uno dei primi ambiti di ricerca di Bostrom, teorico del transumanesimo), teoria dei giochi. Un contributo importante nell’elaborazione di questa macrostrategia è quello di Orda, Hillerbrand e Sandberga (2010), che prende in considerazione come test case la valutazione del rischio dell’acceleratore di particelle LHC al CERN di Ginevra. Nel corso della sua realizzazione, LHC aveva destato preoccupazioni relative alla possibilità – per quanto implausibile – che le alte energie di collisione tra particelle raggiunte nell’acceleratore potessero formare mini-buchi neri, con conseguenze potenzialmente catastrofiche. Gli autori fanno notare che, anche qualora la possibilità di un esito catastrofico di un evento sia di una su un miliardo, il rischio che pone alla civiltà umana è tale da richiedere una nuova ponderazione della sua probabilità. In tal senso, le analisi di rischio di LHC avrebbero inizialmente sottostimato eccessivamente una simile possibilità, sulla base della convinzione che tali buchi neri sarebbero evaporati quasi istantaneamente, come previsto dalle più accreditate teorie fisiche. Solo successivamente, una nuova analisi di rischio condotta nel 2008 ha preso in considerazione più variabili, accettando anche la possibilità che simili buchi neri non evaporino e finiscano per interagire con la materia ordinaria; le stime e le valutazioni compiute in quell’analisi dimostravano comunque che una simile eventualità non avrebbe costituito un rischio per la civiltà, dal momento che anche nello scenario peggiore la velocità di inghiottimento della materia della Terra da parte di un buco nero creato in LHC sarebbe stata inferiore alla durata di vita stimata del nostro pianeta (quindi oltre 4 miliardi di anni). Gli autori ritengono che questo tipo di analisi di rischio sia più consono per la valutazione dei rischi esistenziali, perché prende in considerazione un vasto insieme di variabili e di scenari possibili senza fondarsi esclusivamente su una stima probabilistica. La lezione che gli autori traggono da questo caso studio è che si possa “ridurre la possibilità di pregiudizi inconsapevoli nella fase di valutazione del rischio attraverso il semplice espediente di dividere il gruppo di valutazione in un gruppo ‘blu’ di esperti che effettuano un’obiettiva analisi di rischio e in un gruppo ‘rosso’ di avvocati del diavolo che cercano di dimostrare la possibilità di un rischio, seguita da fasi ripetute di critiche reciproche e aggiornamenti dei modelli e delle stime”.

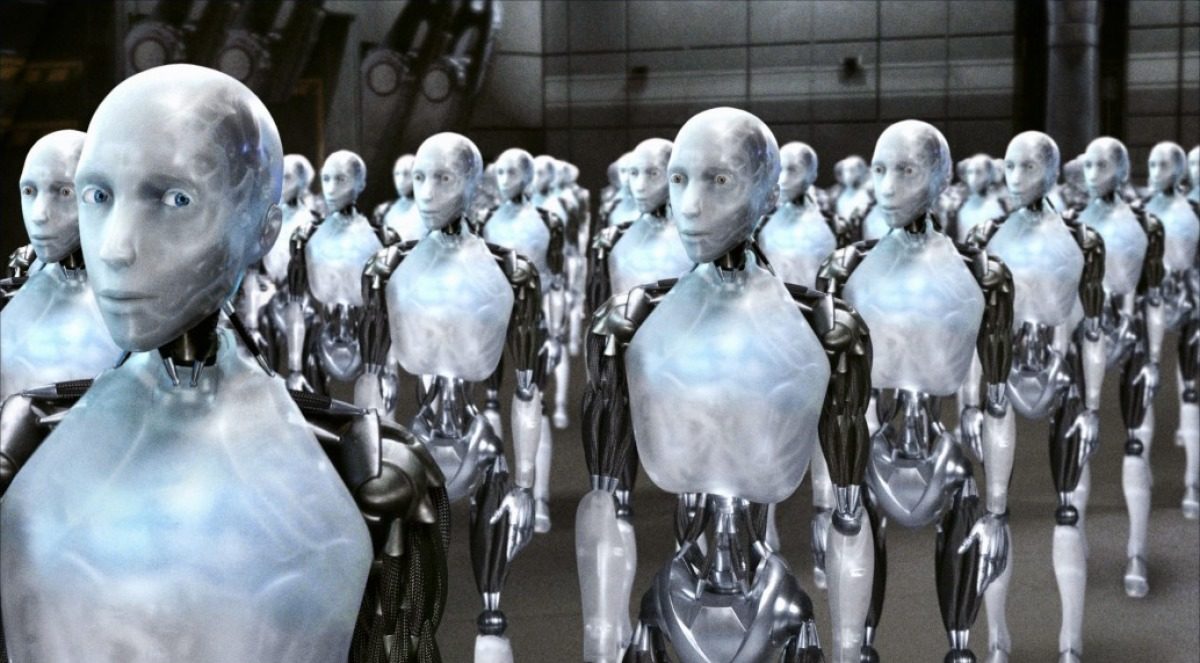

Nella seconda e attuale fase di vita del FHI, l’indirizzo di ricerca prevalente è divenuto quello della sicurezza legata allo sviluppo di intelligenze artificiali “forti”, ossia in grado di acquisire in futuro una consapevolezza di sé. Questo nuovo indirizzo risente del successo del libro di Nick Bostrom Superintelligence: Paths, Dangers, Strategies (2014), nel quale il fondatore e direttore del FHI sostiene che un’intelligenza artificiale di questo tipo finirebbe prima o poi per surclassare l’essere umano come forma di vita principale sulla Terra, ponendo pertanto per la civiltà umana un rischio di livello estintivo. Da qui l’appello di Bostrom a discutere dei modi in cui rendere questa “superintelligenza” compatibile con gli scopi e le finalità della civiltà umana, affinché non ne acquisisca di propri e autonomi rispetto ai nostri. L’influenza di questo testo all’interno della Silicon Valley e in generale degli ambienti dell’imprenditoria digitale più avanzata è stata enorme, come si dirà meglio oltre. Una delle conseguenze è stato il finanziamento da parte del Future of Life Institute, grazie a una donazione del CEO di SpaceX e Tesla Elon Musk, dello Strategic Artificial Intelligence Resarch Centre, istituito nel 2015 all’interno del FHI.

L’agenda di ricerca del centro si divide in due ambiti: sul piano tecnico, l’obiettivo è di risolvere le sfide tecnologiche per la costruzione di sistemi di intelligenza artificiale (AI) che restino sicuri e affidabili anche se dotati di grandi capacità; sul piano strategico, l’obiettivo è di capire in che direzione si evolverà la ricerca e lo sviluppo delle AI sul lungo termine, per intervenire con anticipo in casi in cui lo sviluppo tecnologico minacci di rappresentare un serio rischio per la sicurezza della civiltà umana. Un esempio sul primo versante è lo studio di Orseau e Armstrong (2016) sul modo in cui si può programmare un’AI affinché non impari a disabilitare i sistemi di sicurezza progettati per impedire azioni potenzialmente letali per gli operatori umani e l’ambiente. Non basta infatti, sostengono gli autori, prevedere un “grosso pulsante rosso” che l’operatore umano può premere quando l’AI avvia una sequenza imprevista e pericolosa di azioni: l’AI, grazie all’apprendimento per rinforzo alla base della sua programmazione, potrebbe infatti imparare a disabilitare il pulsante rosso, ossia a impedire che l’operatore umano possa assumere contromisure che ne disabilitino l’azione. Nello studio, gli autori prendono in considerazione possibili algoritmi inseribili nella programmazione dell’AI tali da evitare simili scenari. Un esempio sul secondo versante è fornito dall’analisi di Bostrom (2017) sulla desiderabilità di un’apertura globale nei processi di sviluppo delle AI che superi il tradizionale approccio proprietario. In particolare, un’apertura relativa ai codici sorgente, ai dati, alle tecnologie, agli approcci scientifici potrebbe probabilmente rallentare la corsa alle AI, ma questo non sarebbe necessariamente un male: una maggiore apertura “democratica” permetterebbe alla società civile di prendere parte al dibattito sulla sicurezza delle AI e disinnescherebbe i rischi di una sorta di “corsa agli armamenti” che, come all’epoca del progetto Manhattan, spingerebbe alcuni gruppi a bruciare le tappe per dotarsi per primi di un’AI autocosciente, senza prendere in adeguata considerazione i rischi connessi.

Il Centre for the Study of Existential Risk

Istituito nel 2013 presso l’Università di Cambridge, il Centre for the Study of Existential Risk (CSER) è il primo centro di ricerca a esplicitare fin nel nome il riferimento alla nozione di rischio esistenziale. Co-fondatori del CSER sono Huw Price, noto filosofo della scienza, titolare della cattedra Bertrand Russell all’Università di Cambridge; Lord Martin Rees, che a Cambridge è attualmente professore emerito di Cosmologia e astrofisica; e il co-fondatore di Skype, Jaan Tallinn. Il ruolo di Tallinn come finanziatore del centro è sintomatico del fascino che la nozione di rischio esistenziale esercita su quegli imprenditori che operano alla frontiera dell’innovazione tecnologica e digitale, preoccupati soprattutto dalla possibilità che l’innovazione nel settore informatico possa produrre un giorno AI in grado di sottrarsi al controllo umano. Il tema dell’intelligenza artificiale è indicato non a caso come uno dei primi tra quelli oggetto di analisi da parte del CSER, insieme ai rischi biotecnologici, al cambiamento climatico e ai rischi ecologici, ai rischi connessi alle fragilità sistemiche.

Il CSER è tuttavia principalmente focalizzato sullo sviluppo di una metodologia generale per la gestione di quello che viene definito “rischio tecnologico estremo” (ETR), applicabile non solo agli ambiti d’azione prioritari individuati dal centro, ma che possa fungere da strumento per la gestione dei futuri unknown unknowns, quei rischi che non possiamo attualmente prevedere ma che potrebbero emergere nei futuri sviluppi della ricerca scientifica e tecnologica. Si tratta dunque di sviluppare “metodi e protocolli specificamente disegnati per l’identificazione, la valutazione e la mitigazione di questa classe di rischi”. Nel farlo, il CSER parte dalla constatazione che i tradizionali approcci di analisi costi/benefici possiedono evidenti limiti quando applicati agli ETR, nella misura in cui, per quanto grande possa essere il beneficio, il costo connesso in termini di rischio può rappresentare una minaccia di portata esistenziale all’intera civiltà. Una delle metodologie maggiormente impiegate dal CSER è quella dell’horizon scanning, tipica degli studi di anticipazione: identificando i potenziali ETR ben prima che si presentino consentirebbe un loro studio più sistematico, così da intraprendere per tempo le misure necessarie a mitigarli o addirittura impedirli. Se, per esempio, durante il progetto Manhattan ci fosse stato il tempo e la lucidità mentale per comprendere i rischi esistenziali legati allo sviluppo delle armi nucleari, in un contesto diverso da quello dell’epoca (in piena Seconda guerra mondiale) la comunità scientifica avrebbe forse deciso per una moratoria internazionale sulla ricerca e sviluppo del nucleare militare. Su un piano più filosofico, il CSER si concentra sullo studio dei limiti del tradizionale principio di precauzione e sui vantaggi derivanti dall’applicazione del concetto di “ricerca e innovazione responsabile”, coniato all’interno della Commissione europea negli anni scorsi come criterio-guida per i programmi di ricerca europei, al fine di coinvolgere in modo attivo l’opinione pubblica nel dibattito sull’impatto sociale della ricerca tecnologica, per favorire una maggiore consapevolezza del rischio e della responsabilità sociale senza per quanto scoraggiare i processi di innovazione.

Huw Price e Seán Ó hÉigeartaigh (2014) hanno preso per esempio in considerazione il caso della geoingegneria, proposta da più parti come una possibile soluzione radicale per la mitigazione del cambiamento climatico. Ma, sebbene alcune delle tecnologie proposte siano già oggi disponibili – per esempio immettere in atmosfera importanti quantità di aerosol solfati per ridurre l’irraggiamento solare, o inseminare alcune aree degli oceani con una certa quantità di ferro per aumentare la crescita del plancton, che svolge un ruolo decisivo nel sequestro di anidride carbonica atmosferica – non esistono al momento studi sulle loro conseguenze sul lungo periodo. Solo un più ampio e sistematico impiego di strumenti propri della previsione e dell’anticipazione potrebbe consentirci di avere un quadro più chiaro delle conseguenze sul lungo termine di simili tecnologie, i cui effetti collaterali possono altrimenti avere una portata globale difficilmente stimabile.

Il Future of Life Institute

Fortemente influenzato dalle tesi espresse da Bostrom in Superintelligence, nel 2014 viene istituito a Cambridge, Massachusetts il Future of Life Institute (FLI). Co-fondatori sono Jaan Tallinn, già co-fondatore del CSER; Max Tegmark, docente di cosmologia al MIT, che con Bostrom collabora da tempo (i due hanno firmato nel 2005 un articolo per Nature dal titolo How Unlikely is a Doomsday Catastrophe?); la moglie Meita Chita-Tegmark, dottoranda in scienze dello sviluppo all’Università di Bostron; Viktorya Krakovna, ricercatrice della compagnia DeepMind; ed Anthony Aguirre, docente di fisica all’Università della California a Santa Cruz, co-fondatore con Tegmark del Foundational Questions Institute. Nel gennaio 2015 il FLI organizza a Puerto Rico il suo primo convegno, dedicato al futuro delle AI, coinvolgendo alcuni degli esperti mondiali del settore e discutendo con loro di questioni economiche, etiche e legali dello sviluppo delle AI. Successivamente a questo convegno, il FLI pubblica una lettera aperta sulla sicurezza delle AI che verrà firmata da circa 7000 esperti, tra cui il fisico Stephen Hawking e l’imprenditore Elon Musk, il quale decide di finanziare con 10 milioni di dollari il FLI per portare avanti un programma di ricerca sul tema della sicurezza delle AI.

Nell’elencare le priorità di questo programma di ricerca, Russell, Dewey e Tegmark (2015) le dividono in priorità di breve e di lungo termine. Tra le prime rientra la necessità di ottimizzare l’impatto economico delle AI, in particolare attraverso strumenti di anticipazione delle conseguenze sul mercato del lavoro (il timore di un’automazione crescente che aumenti la cosiddetta “disoccupazione tecnologica”), e di fenomeni di market disruption, con la scomparsa di interi comparti produttivi, come già avvenuto in passato sull’onda dell’innovazione digitale; ciò richiederà una più incisiva azione politica tesa a favorire la formazione per i settori professionali ad alta qualificazione, più al riparo dal rischio di automazione nei prossimi anni, e ad adottare nuove politiche di welfare. Tra le priorità di breve termine, gli autori citano anche quelle legate al diritto e all’etica delle AI, in particolare la normativa per il nascente mercato delle auto senza conducente (per es. la responsabilità per danni), le questioni di privacy e la possibilità di mettere al bando le cosiddette “armi autonome”, sistemi bellici dotati di AI in grado di agire in modo autonomo rispetto all’operatore umano. Tra le priorità di lungo termine, invece, data la difficoltà predittiva dell’evoluzione delle AI, gli autori suggeriscono di lavorare su questioni più generali, come la validazione dei sistemi di garanzia della “robustezza” e sicurezza delle AI. Poiché è ipotizzabile che, nei prossimi decenni, le AI raggiungono in alcuni campi capacità superiori a quelle umane, è d’obbligo fin da subito lavorare nella progettazione di sistemi affidabili, sulla scia di quanto peraltro aveva già proposto il Future of Humanity Institute nelle sue precedenti. Gli autori sono convinti che nei prossimi anni la ricerca sulle AI metterà a disposizione della civiltà umana delle tecnologie in grado di far compiere un gigantesco balzo in avanti in termini di benefici e opportunità, ma sottolineano l’esigenza di prendere fin da subito provvedimenti che massimizzino questi benefici e riducano al minimo i possibili impatti negativi delle AI tanto nel breve quanto nel lungo termine.

In questa direzione vanno due iniziative più recenti promosse dal FLI: la lettera aperta del luglio 2015 con cui numerosi esperti di robotica e AI hanno chiesto una moratoria internazionale sulle cosiddette “armi autonome”, nella direzione di una loro messa al bando attraverso un trattato internazionale delle Nazioni Unite; e la conferenza sui benefici delle AI tenuta nel gennaio 2017 ad Asilomar, località simbolica perché nel 1975 vi si tenne la celebre conferenza sulla tecnologia del DNA ricombinante, che vide la comunità scientifica adottare volontariamente una serie di linee guida per il proseguimento della ricerca in questo delicato settore, le cui conseguenze sul lungo termine non erano prevedibili, sulla base del principio di precauzione. Ad Asilomar gli esperti intervenuti nel 2017 hanno adottato un elenco di 23 principi-guida sulla politica di ricerca, le questioni etiche, i valori e gli aspetti di lungo termine della ricerca sulle AI. Il principio 21, strettamente legato al tema dei rischi esistenziali, afferma che i rischi catastrofici ed esistenziali posti dalle AI devono essere soggetti a sforzi di pianificazione e mitigazione commisurati al loro possibile impatto. Ciò rappresenta, a oggi, la più compiuta nozione operativa di mitigazione del rischio esistenziale, destinata senza dubbio a orientare il dibattito sulla governance del progresso scientifico e tecnologico di lungo periodo.

Conclusioni: dal principio di precauzione al rischio esistenziale

Nel suo celebre saggio Il principio responsabilità del 1979, il filosofo tedesco Hans Jonas sosteneva che la crisi ecologica che l’umanità stava iniziando ad affrontare (in un’epoca in cui, peraltro, il cambiamento climatico non era ancora un argomento) era da imputare a uno sviluppo scientifico e tecnologico sfrenato, in assenza di un quadro etico aggiornato che potesse fungere da guida. L’umanità era invece ormai entrata in quella che il sociologo Ulrich Beck avrebbe successivamente definito “l’età del rischio”, in cui il potere tecnologico assume una capacità tale da minacciare l’equilibrio naturale. In una simile epoca, secondo Jonas, occorre che la responsabilità travalichi le relazioni interumane e tra la nostra specie e la biosfera nel tempo presente, incorporando nelle sue previsioni sul futuro la consapevolezza sugli effetti di lungo termine. L’umanità dovrebbe dunque acquisire una responsabilità nei confronti delle generazioni a venire e del mondo che esse erediteranno. Esistono tuttavia degli evidenti limiti nell’applicazione del principio responsabilità, in particolare di ciò che Seth Baum (2015) definisce il far future argument, secondo cui “le persone dovrebbero preoccuparsi della civiltà umana nel lontano futuro e, al fine di conseguire benefici nel lontano futuro, dovrebbero cercare di confrontarsi con queste minacce catastrofiche”. Esiste una reticenza strutturale della nostra specie a preoccuparsi del lontano futuro, spiega Baum. È dimostrato che le persone preferiscono spendere i propri soldi per aiutare i propri amici e parenti più stretti piuttosto che persone che non conoscono e che vivono in aree distanti del pianeta: è pertanto probabile che la loro propensione alla spesa per i membri delle generazioni a venire sia molto bassa; i sistemi elettorali attuali favoriscono inoltre decisioni di breve termine, inadeguate ad affrontare le minacce poste dai rischi esistenziali; e le stesse politiche economiche democratiche basate sul libero mercato, nonostante i loro indubbi vantaggi, possiedono una minore propensione alla pianificazione di lungo termine rispetto ai regimi più autoritari.

Il testo di Jonas è considerato oggi uno dei capisaldi del pensiero che ha portato alla formalizzazione del noto “principio di precauzione”, la cui definizione sistematica viene fatta risalire alla Dichiarazione di Rio del 1992, durante il primo Earth Summit: “Al fine di proteggere l’ambiente, un approccio cautelativo dovrebbe essere ampiamente utilizzato dagli Stati in funzione delle proprie capacità. In caso di rischio di danno grave o irreversibile, l’assenza di una piena certezza scientifica non deve costituire un motivo per differire l’adozione di misure adeguate ed effettive, anche in rapporti ai costi, dirette a prevenire il degrado ambientale”. Il problema del principio di precauzione sta nel fatto che, in una società che non è incentivata a proiettarsi sul lungo termine e non coltiva una reale responsabilità nei confronti delle generazioni a venire, la sua applicazione può comportare conseguenze dannose per il progresso tecnoscientifico. Un esempio lampante è dato dalla normativa europea in tema di organismi geneticamente modificati (OGM). L’Unione europea, che ha incorporato nella sua legislazione il principio di precauzione, ha a lungo ostacolato l’introduzione nei paesi europei di sementi e di altri prodotti OGM, decidendo solo piuttosto recentemente di consentirla in quei paesi membri che si pronuncino favorevolmente, previa una rigorosa valutazione scientifica del rischio per ciascun prodotto importato, anche per quanto attiene gli effetti di lungo termine sulla biosfera, l’ecosistema e la salute umana. Si potrebbe pensare che questa normativa rifletta le indicazioni proposte dai sostenitori della nozione di rischio esistenziale, ma non è così: nel momento in cui la comunità scientifica mondiale ha raggiunto un consenso più o meno unanime ormai da tempo sull’assenza di pericoli anche sul lungo termine degli OGM, insistere su un approccio tanto precauzionale ha il solo effetto di intralciare la ricerca e lo sviluppo in questo settore.

Riccardo Campa (2016) ha dimostrato che l’avversione agli OGM risente di una “sindrome del Giardino dell’Eden” propria dei movimenti ambientalisti, nel cui alveo si è formato e consolidato il principio di precauzione, tale per cui ogni intervento umano nella Natura è da considerarsi di per sé deleterio e rischioso. Viceversa, i proponenti della nozione di rischio esistenziale sono personalità note per il loro approccio propositivo nei confronti della ricerca scientifica e tecnologica, tanto che lo stesso ideatore del concetto, Bostrom, è stato tra i padri fondatori del movimento transumanista, che sostiene il diritto della specie umana di migliorarsi grazie alle innovazioni biomediche per meglio adattarsi all’ambiente e alle sue trasformazioni. Inoltre, i centri di ricerca attivi nel settore dei rischi esistenziali fanno ampio uso, come si è visto, di strumenti propri della previsione sociale e dei futures studies, necessari per anticipare le possibili conseguenze deleterie dell’innovazione scientifica e tecnologica e intervenire per tempo per evitare o minimizzare questo tipo di rischi. L’attività di valutazione del rischio esistenziale è di per sé anticipante, perché agisce con largo anticipo rispetto al compiuto sviluppo di un’innovazione potenzialmente pericolosa, e non dopo che l’innovazione è stata sviluppata o introdotta sul mercato. In conclusione, la sostituzione del principio di precauzione, che mostra oggi tutti i suoi limiti, in funzione dell’adozione della nozione di rischio esistenziale come principio-guida per la governance del progresso tecnoscientifico, può risultare di grande utilità ed efficacia per la salvaguardia delle future generazioni, senza compromettere quello sviluppo scientifico necessario affinché la civiltà umana riesca a tenersi al passo dei cambiamenti propri di una società interconnessa che richiede sempre nuove soluzioni a nuovi problemi.

Bibliografia

- Baum S.D., The Far-Future Argument for Confronting Catastrophic Threats to Humanity: Practical Significance and Alternatives, “Futures”, vol. 72, 2015.

- Bostrom N., Superintelligence: Paths, Dangers, Strategies, Oxford University Press, 2014.

- Bostrom N., Strategic Implications of Openess in AI Development, “Global Policy”, vol. 8 n. 2, maggio 2017.

- Bostrom N., Cirkovic M.M., Global Catastrophic Risks, Oxford University Press, 2011.

- Campa R., Creatori e creature. Anatomia dei movimenti pro e contro gli OGM, D Editore, Ladispoli, 2016.

- Jonas H., Il principio responsabilità. Un’etica per la civiltà tecnologica, Einaudi, Torino, 2009.

- Ord T., Hillerbrand R., Sandberg A., Probing the improbable: methodological challenges for risks with low probabilities and high stakes, «Journal of Risk Research», vol. 13 no. 2, 2010.

- Orseau L., Armstrong S., Safely Interruptible Agents, in «Uncertainty in Artificial Intelligence», Proceedings of the 32d Conference, Jersey City, NJ, USA, 2016.

- Price H., hÉigeartaigh S.O., Policy, Decision Making and Existential Risk, in Innovation: managing risk, not avoiding it, Annual Report of the Government Chief Scientific Adviser, Government Office for Science, Londra 2014.

- Russell S., Dewey D., Tegmark M., Research Priorities for Robust and Beneficial Artificial Intelligence, “AI Magazine” vol. 36 n. 4, dicembre 2015.

[…] a un passato contraddistinto dall’assenza di questa consapevolezza. Dalle dotte disquisizioni sul rischio esistenziale, seguite da tutto il carrozzone del colto eco-millenarismo secolarizzato che Alexander Galloway ha […]

[…] Paura, R. (2017), Il concetto di rischio esistenziale come strumento di anticipazione nella governance del progresso scientifico, “Futuri”, 18 luglio, https://www.futurimagazine.it/articoli/in_evidenza/rischio-esistenziale-anticipazione-governance-pro… […]